AI 网络革命!NVIDIA亮出CPO硅光交换机与AI 数据平台两大“神器”

2025-03-19

22:08:48

来源: 杜芹

点击

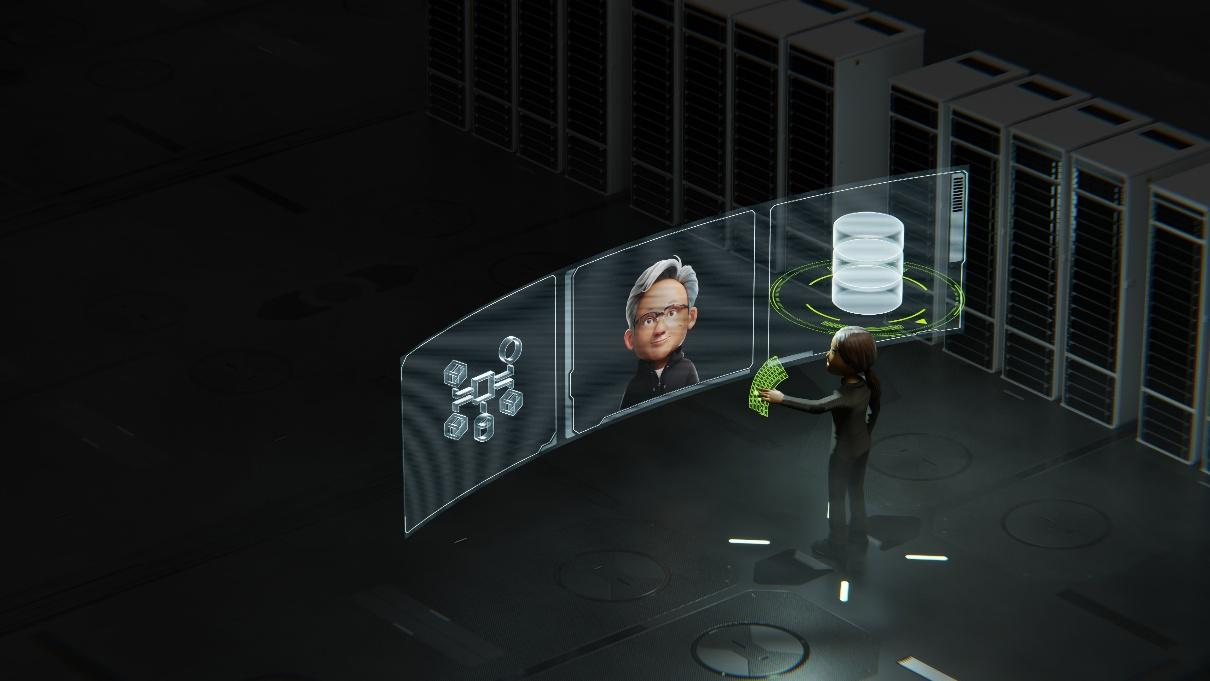

在人工智能飞速发展的浪潮中,算力芯片的性能提升无疑是核心驱动力,然而,随着 AI 应用场景的日益复杂,网络连接与数据处理能力的重要性正逐步凸显。在 2025 年 3 月 18 日召开的 GTC 大会上,NVIDIA 以其前瞻性的技术视野,推出了光电一体化封装(CPO)技术和 NVIDIA AI 数据平台这两大创新成果。这不仅标志着 NVIDIA 在 AI 基础设施领域的全新突破,也为构建百万 GPU 级别的 AI 工厂和企业智能化转型提供了强有力的技术支撑,开启了 AI 生态系统的新篇章。

硅光革命!百万GPU不再是梦

在本次GTC 大会上,NVIDIA 公布了光电一体化封装(CPO)技术路线图的重磅产品——NVIDIA Spectrum-X 和 NVIDIA Quantum-X 硅光网络交换机。这一发布标志着 NVIDIA 在 AI 基础设施领域的又一次突破。NVIDIA 创始人兼首席执行官黄仁勋在会上表示:“NVIDIA 将硅光直接集成到交换机中,打破了超大规模和企业网络的旧有限制,为百万 GPU AI 工厂打开了大门。”

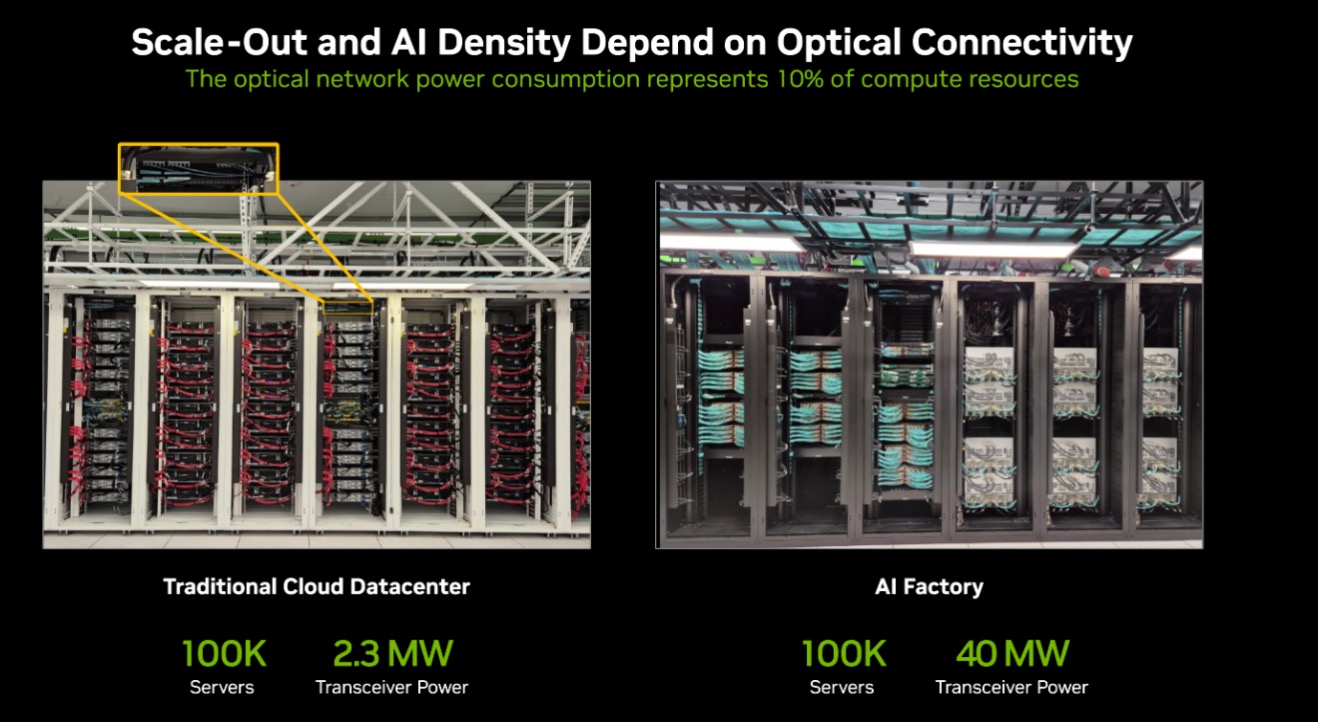

随着 AI 计算的快速普及,传统云数据中心已难以满足现代 AI 工厂对高带宽、低延迟和高能效的需求。AI 工厂的核心在于大规模 GPU 集群的协同工作,而光互连技术成为支撑其性能的关键一环。据统计,在同样搭载 10 万台服务器的数据中心中,传统云数据中心的光收发器功耗仅为 2.3 兆瓦(MW),而 AI 工厂则高达 40 兆瓦,增长近 20 倍。如今,光网络能耗已占 AI 计算资源的 10%,成为性能扩展和成本控制的瓶颈。

传统基于电信号传输的网络架构在信号损耗、功耗和扩展性上面临严峻挑战。而 CPO 技术的出现,通过将光学元器件(如激光器、光调制器和光探测器)与核心计算芯片直接封装,彻底改变了数据传输方式。相比传统方案,CPO 用光信号替代电信号,大幅减少了芯片到光学接口之间的信号损耗,不仅实现了数据吞吐量的指数级提升,还显著降低了能耗。这种技术革新为 AI 工厂的超大规模部署提供了坚实支撑。

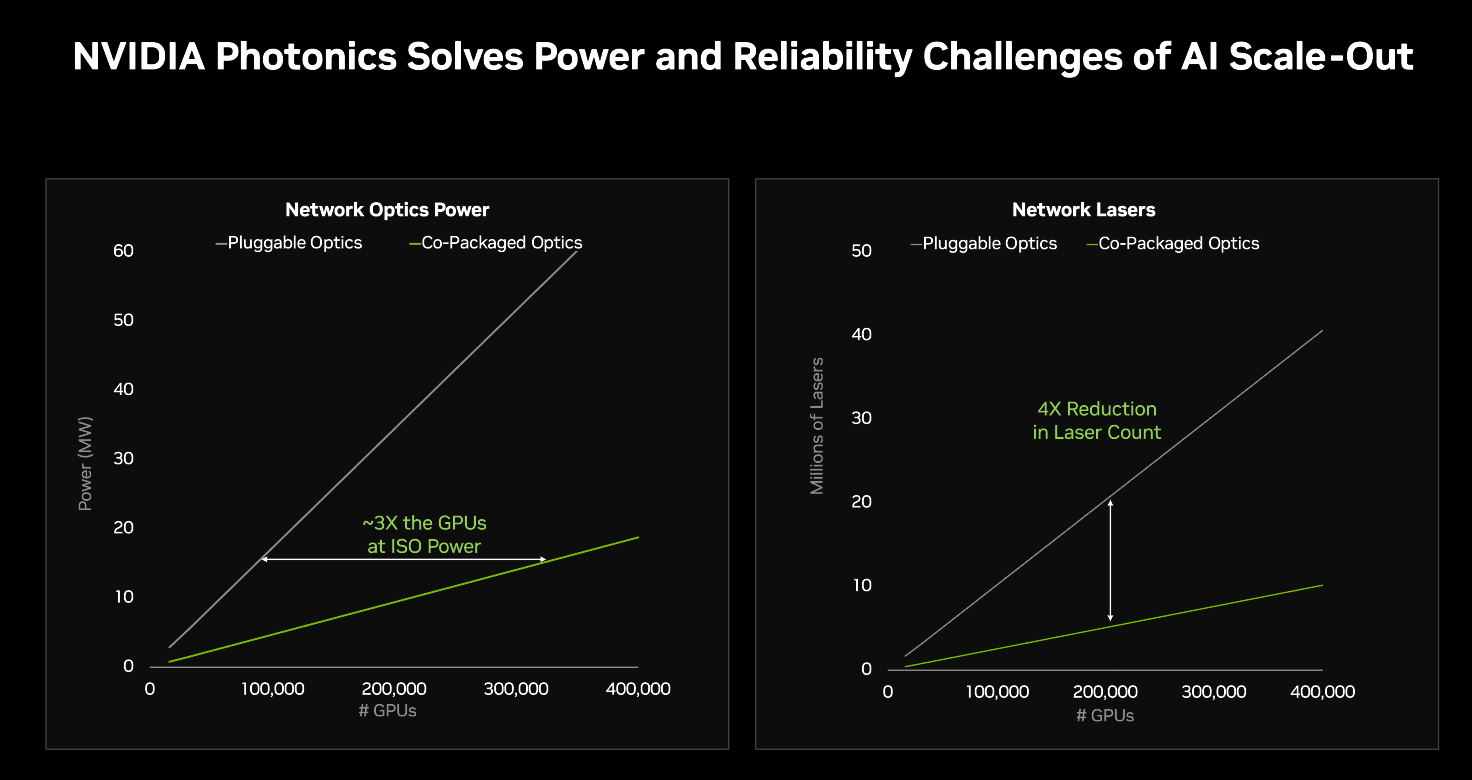

NVIDIA 此次推出的硅光网络交换机展现了 CPO 技术的显著优势。与传统方法相比,该方案将激光器数量减少 4 倍,能源效率提升至 3.5 倍,信号完整性提高到 63 倍,大规模组网可靠性提升到 10 倍,部署速度加快至 1.3 倍。这些数据表明,CPO 不仅优化了网络性能,还降低了系统复杂性和长期运维成本。

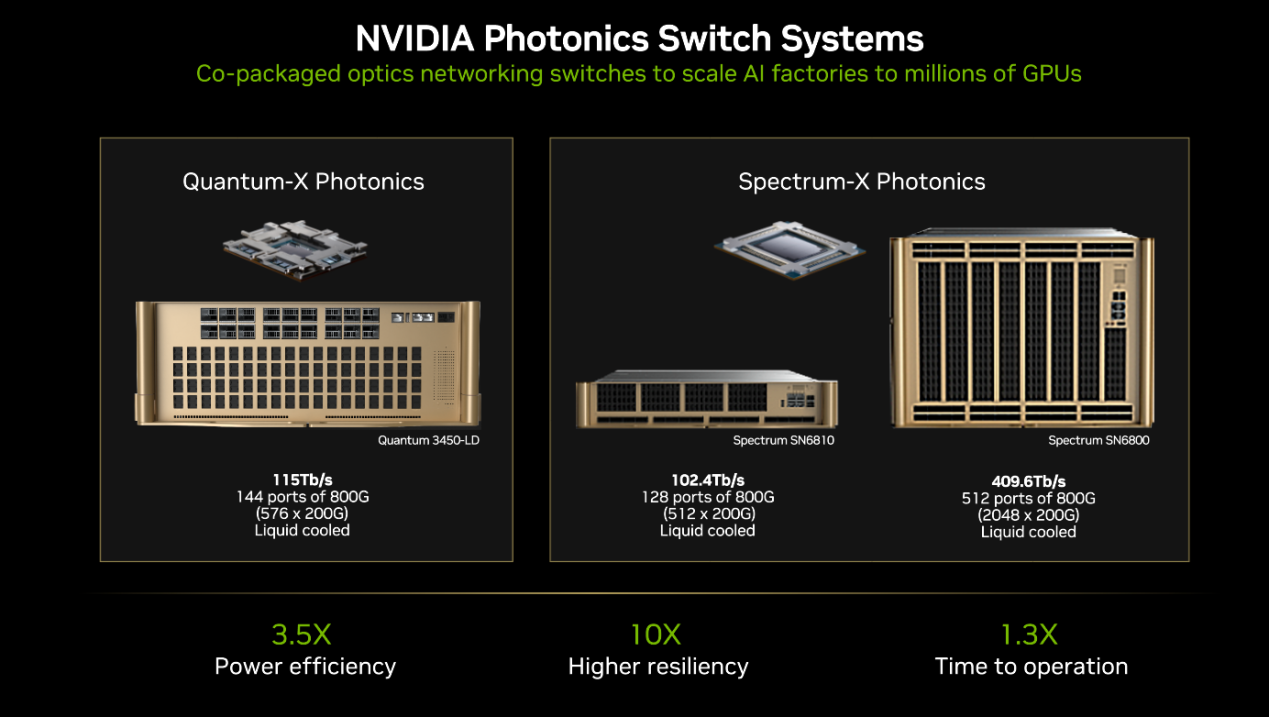

对于 NVIDIA 来说,CPO 的推进与其以太网网络设备的发展相吻合。以太网网络设备连接数据中心的 AI 服务器集群。目前,NVIDIA 计划推出三种不同的带有CPO的交换机,如下图所示:

NVIDIA Quantum-X Photonics交换机可以提供144个基于200Gb/s SerDes 的800Gb/s InfiniBand端口,并采用液冷设计对板载硅光器件进行高效散热。NVIDIA Quantum-X Photonics 交换机 AI 计算网的速度是上一代产品的 2 倍,扩展性是上一代产品的 5 倍。该交换机预计在今年晚些时候上市。

另外的NVIDIA Spectrum-X Photonics交换机具有两种配置,包括 128 个 800 Gb/s 端口或 512 个 200 Gb/s 端口,总带宽可达到 100 Tb/s,以及 512 个 800 Gb/s 或 2,048 个 200 Gb/s 端口,总吞吐量可达 400 Tb/s。该交换机则预计在2026年推出。

通过CPO技术,NVIDIA实现了在降低能耗的同时,提高了网络基础设施的效率和扩展能力。从具体数据上来看,在相同功耗条件下,采用CPO技术的AI工厂能够支持 3 倍数量的GPU,相比传统可插拔光模块,大幅提高了计算集群的可扩展性。此外,CPO 技术可将光网络所需的激光器数量减少 4 倍,有效降低系统复杂性,提高可靠性,同时降低长期运维成本。

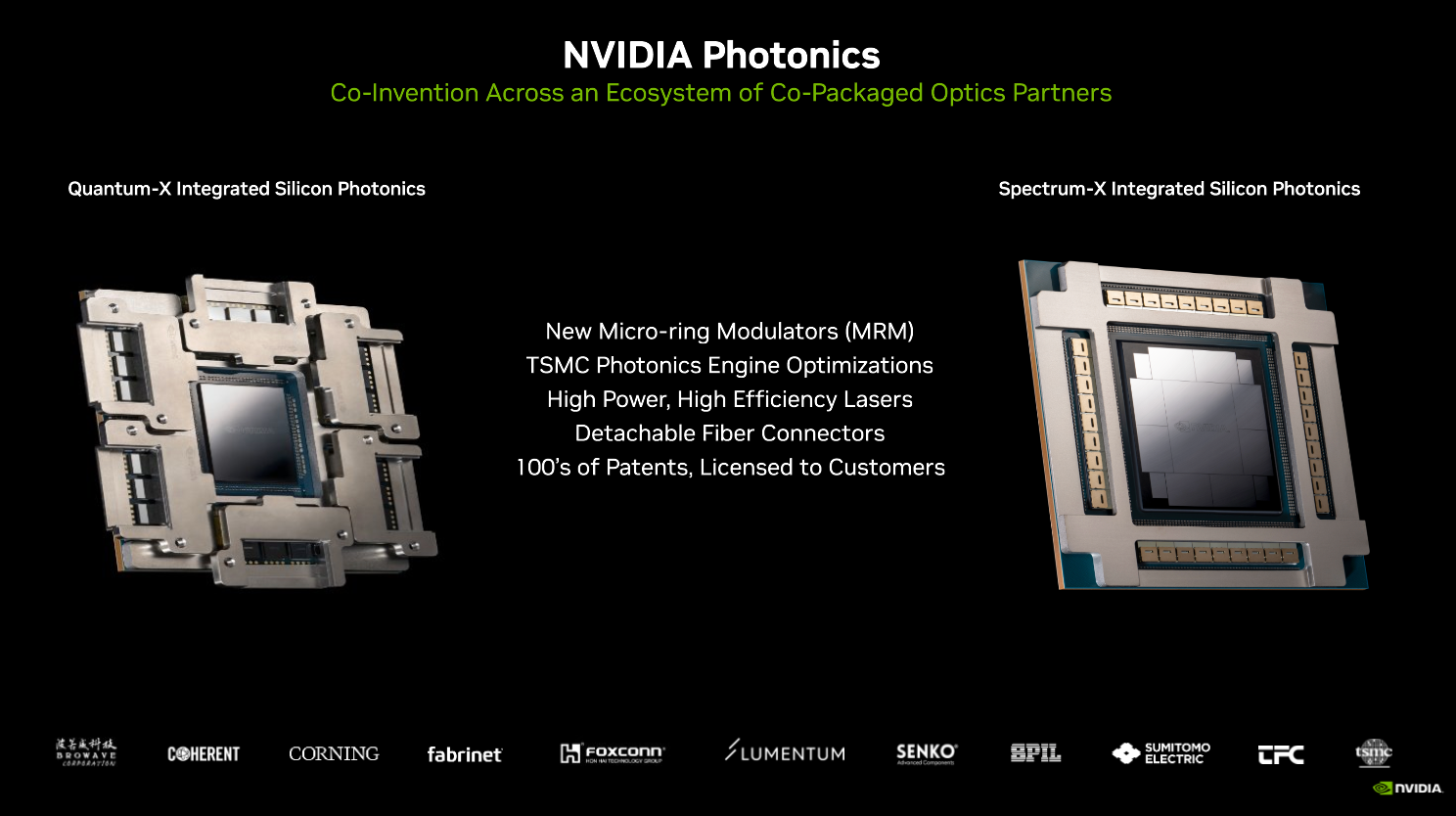

NVIDIA 的 CPO 技术并非单打独斗,其背后是一个强大的硅光生态系统。目前,NVIDIA 已与 TSMC、Browave、Coherent、Corning、Fabrinet、Foxconn、Lumentum、SENKO、SPIL、Sumitomo Electric 和 TFC Communication 等行业巨头建立合作关系,共同推动 CPO 的研发与商用化。

TSMC董事长兼 CEO 魏哲家表示。“TSMC 的硅光解决方案结合了我们先进的芯片工艺和 TSMC-SoIC 3D 芯片封装的优势,帮助 NVIDIA 充分发挥 AI 工厂的能力,助力 AI 工厂扩展到 100 万 GPU 甚至更多,突破 AI 的边界。”这一表态显示了 TSMC 在 CPO 供应链中的关键角色。此外,Coherent、Eoptolink、Fabrinet 和 Innolight 等领先企业也在可插拔光模块技术上与 NVIDIA 形成互补,共同推动下一代 AI 工厂的发展。

AI 数据平台:重塑企业AI存储与推理基础设施

在光电一体化封装(CPO)交换机之外,作为加速计算领域的技术先锋,NVIDIA 将目光投向了数据这一AI 时代的核心资产,推出了 NVIDIA AI 数据平台。这是一款可高度定制的参考设计,旨在为领先的存储提供商提供技术支持,帮助其打造满足 AI 推理工作负载苛刻需求的全新企业级 AI 基础设施。

NVIDIA AI 数据平台的核心在于其为存储系统注入的强大加速计算和 AI 能力。该平台搭载了 NVIDIA Blackwell GPU、BlueField DPU 和 Spectrum-X 网络技术,构成了一套高效的“加速引擎”。据 NVIDIA 官方数据,BlueField DPU 的性能较传统基于 CPU 的存储系统提升最高可达 1.6 倍,同时功耗降低达 50%,每瓦性能提升超过 3 倍。而 Spectrum-X 网络通过动态路由和优化的拥塞控制技术,将 AI 存储流量的处理速度提升高达 48%,显著优于传统以太网方案。

此外,该平台还集成了 NVIDIA AI Enterprise 软件套件,包括全新推出的 NVIDIA Llama Nemotron 推理模型的 NIM™ 微服务,以及 NVIDIA AI-Q Blueprint。这些工具使企业能够近乎实时地生成数据洞察,快速响应复杂查询。AI 查询智能体依托 AI-Q Blueprint 和 NeMo™ Retriever 微服务,能够将数据提取和检索速度提升高达 15 倍,支持处理包括文本、PDF、图像和视频在内的多种数据类型,覆盖结构化、半结构化和非结构化数据。

NVIDIA AI 数据平台的推出得到了众多行业领先存储企业的积极响应。DDN、Dell Technologies、Hewlett Packard Enterprise(HPE)、Hitachi Vantara、IBM、NetApp、Nutanix、Pure Storage、VAST Data 和 WEKA 等知名厂商已宣布与 NVIDIA 合作,将该平台的技术能力融入其产品线,打造定制化的 AI 数据解决方案。

NVIDIA AI 数据平台的发布正值企业对 AI 推理需求激增之际。随着生成式 AI 和代理式 AI(Agentic AI)的广泛应用,企业需要更高效、更灵活的基础设施来处理海量数据并生成实时洞察。NVIDIA 的这一举措精准抓住了市场需求,通过与存储行业的深度整合,为企业提供了一个从硬件到软件的全栈式解决方案。

据NVIDIA官方消息,经 NVIDIA 认证的存储提供商将于本月起陆续推出基于该平台构建的解决方案。可以预见,随着这些产品逐步推向市场,企业将在数据管理和 AI 应用方面迎来新一轮技术升级。

结语

在 AI 技术迅猛发展的当下,算力与网络的协同进化已成为推动产业升级的关键驱动力。NVIDIA 在 2025 年 GTC 大会上推出的光电一体化封装(CPO)技术和 AI 数据平台,不仅展现了其在硬件创新上的深厚实力,也为 AI 基础设施的未来发展描绘了清晰蓝图。CPO 技术通过硅光交换机的突破,使 AI 工厂得以扩展至百万 GPU 级别,解决了高带宽、低延迟和能效优化的核心难题;而 AI 数据平台则通过加速计算与存储的深度融合,为企业提供了高效处理海量数据的能力。这两大创新相辅相成,分别从网络连接和数据处理两个维度重塑了 AI 生态的底层架构。

责任编辑:admin

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻