2025 GTC:NVIDIA AI软件三剑齐发

2025-03-20

13:48:55

来源: 杜芹

点击

人工智能(AI)的快速发展离不开硬件算力的飞跃,但软件作为AI生态的灵魂,在推动技术进步、优化性能和实现广泛应用方面扮演着不可替代的角色。在2025年GTC大会上,NVIDIA以一系列AI软件领域的突破性进展,再次巩固了其在人工智能技术前沿的领导地位。

NVIDIA AI-Q Blueprint:开启AI智能体协作新范式

AI智能体作为新兴的数字化劳动力,正在重塑企业运营模式。通过自动执行复杂任务并协同解决跨领域难题,这些智能体正成为释放效率的关键。NVIDIA此次发布的AI-Q Blueprint和AgentIQ工具包,为企业快速构建具备推理能力的多智能体系统提供了坚实基础。

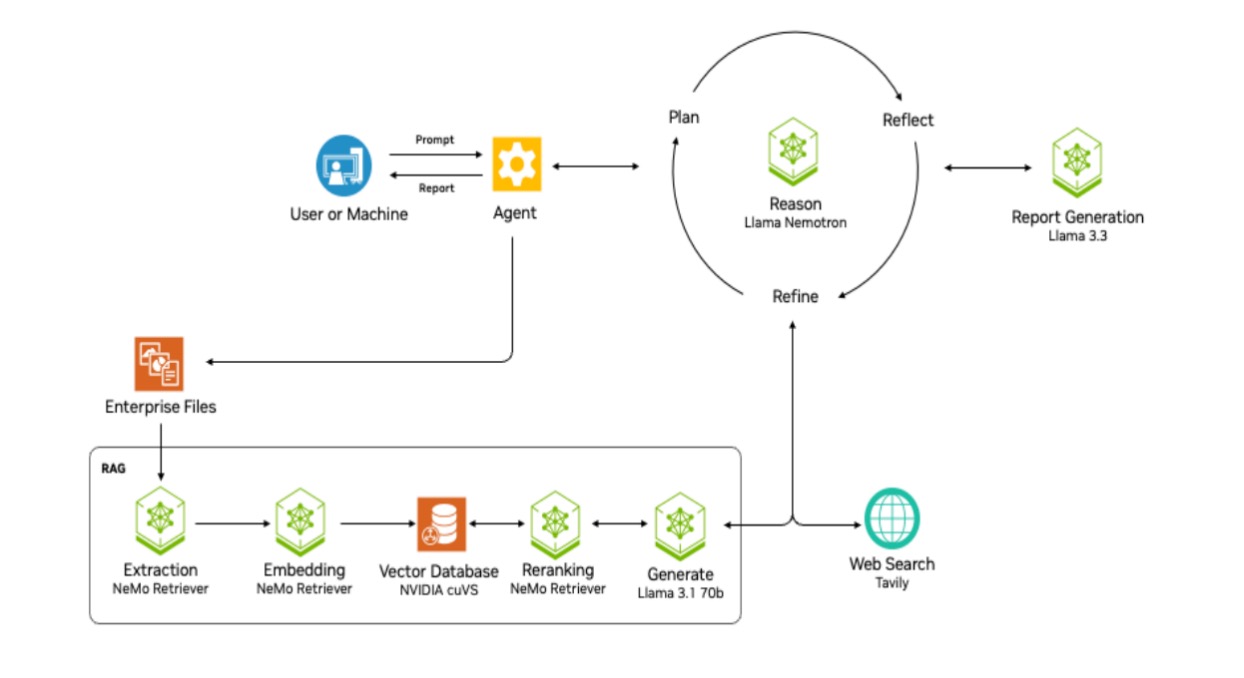

AI-Q Blueprint整合了NVIDIA加速计算技术、合作伙伴存储平台以及包括全新Llama Nemotron推理模型在内的软件工具,旨在打破智能体间的“孤岛效应”。通过NVIDIA NeMo Retriever和NIM微服务的多模态提取与检索功能,企业可将内部数据转化为智能体的知识源,从而实现快速、精准的任务处理。值得一提的是,AgentIQ工具包作为开源软件,已于GitHub上线。它不仅支持智能体与现有框架的无缝集成(如CrewAI、LangGraph、Microsoft Azure AI Agent Service等),还通过系统可追溯性和性能分析提升透明度,帮助企业优化AI团队的协作效能。

图源:NVIDIA

实际应用中,AI-Q与AgentIQ已展现出跨行业的潜力。例如,金融服务巨头Visa利用AI-Q的分析功能优化网络安全智能体,大幅提升了网络钓鱼邮件的自动化检测效率。而Salesforce的Agentforce、Atlassian的Rovo以及ServiceNow的AI平台,也通过这些工具实现了任务响应时间从数天缩短至数小时的飞跃。NVIDIA Metropolis VSS蓝图更进一步,将视觉感知与语音、翻译等功能结合,展示了AI-Q在多模态智能体开发中的广泛适用性。

对于开发者而言,AgentIQ的开源性质和与主流框架的兼容性降低了进入门槛。企业IT团队则可借助这些工具,将AI智能体作为“数字员工”进行培训与管理,从而推动业务流程的全面智能化。

NVIDIA Llama Nemotron推理模型:开放AI新动能

NVIDIA在GTC上推出的Llama Nemotron推理模型系列,是其开放策略的重要一步。这一基于Llama模型打造的开源系列,通过后训练增强了多步数学运算、编码和复杂决策能力,精度较基础模型提升20%,推理速度比其他领先开放模型快5倍。这不仅降低了企业AI部署的成本,也为构建高效智能体平台提供了生产就绪型基础。

图源:NVIDIA

Llama Nemotron系列包括Nano、Super和Ultra三种规模,分别针对边缘设备、单GPU高吞吐量以及多GPU服务器的高精度需求。NVIDIA在DGX Cloud上利用高质量合成数据进行后训练,并将相关工具与数据集全面开放,为企业自定义推理模型提供了灵活性。NIM微服务则进一步简化了模型部署流程,确保其在生产环境中的可靠性。

多家行业巨头已率先拥抱这一技术。微软将其集成至Azure AI Foundry,扩展了Microsoft 365的智能体服务能力;SAP通过Llama Nemotron提升了Joule智能副驾的代码补全精度,推动SAP Business AI的创新;ServiceNow和埃森哲则分别利用其增强企业生产力和行业定制化智能体开发。德勤的Zora AI平台也计划采用该模型,为特定行业提供透明且功能强大的AI支持。

NVIDIA创始人兼CEO黄仁勋强调:“推理和代理式AI的采用速度令人惊叹。我们提供的开放模型和工具,将为全球开发者与企业构建高效AI团队奠定基础。”Llama Nemotron系列预计将于4月全面可用,开发者现可通过NVIDIA官网和Hugging Face获取Nano与Super模型的API,NVIDIA AI Enterprise用户则可将其部署于生产环境。

NVIDIA Dynamo:AI工厂的推理加速引擎

随着AI推理需求的激增,如何在保持高性能的同时降低成本,成为AI服务提供商的核心挑战。NVIDIA Dynamo作为Triton推理服务器的继任者,以开源形式亮相,旨在为AI工厂提供高效、低成本的推理解决方案。

图源:NVIDIA

Dynamo通过智能调度和分离服务优化了GPU资源利用率。它将大语言模型的处理阶段拆分至不同GPU,动态分配资源以应对请求波动,并在大型集群中实现精准路由。例如,在Hopper平台上运行Llama模型时,Dynamo将性能提升一倍;在GB200 NVL72机架上运行DeepSeek-R1模型时,单GPU token生成量提升超30倍。此外,其显存管理器可将推理数据卸载至低成本存储,并在需要时快速检索,进一步压低成本。

Dynamo支持PyTorch、TensorRT-LLM等主流框架,并已吸引亚马逊云科技、Cohere、Together AI等合作伙伴的关注。Perplexity AI CTO Denis Yarats表示:“Dynamo的分布式服务能力将显著提升我们的推理效率,满足亿级请求的需求。”Together AI则计划将其专有推理引擎与Dynamo集成,实现跨节点无缝扩展。

Dynamo的关键创新包括GPU规划器、智能路由器、低延迟通信库和显存管理器,这些组件共同提升了吞吐量并改善用户体验。未来,该软件将融入NVIDIA AI Enterprise平台,提供企业级的支持与安全性。

结语

在AI发展的历史进程中,软件不仅是技术的实现手段,更是创新的催化剂。它连接了算法、硬件和应用场景,优化了性能与成本,推动了AI从理论研究走向产业化实践。从AI-Q Blueprint的智能体协作,到Llama Nemotron的推理能力,再到Dynamo的性能优化,NVIDIA在2025 GTC上展示了一套完整的AI软件生态。这不仅是对其硬件霸主地位的补充,更是对AI产业未来的深远布局。可以预见,随着软件技术的不断演进,AI将在更多领域释放变革性潜力。

责任编辑:admin

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻