Meta和甲骨文拥抱英伟达Spectrum-X,以太网的“第二次革命”?

2025-10-14

21:30:44

来源: 杜芹

点击

在万亿参数模型正把数据中心推向前所未有规模的当下,网络不再只是“互联设备”的工具,而是决定训练效率、成本与可扩展性的关键基础设施。

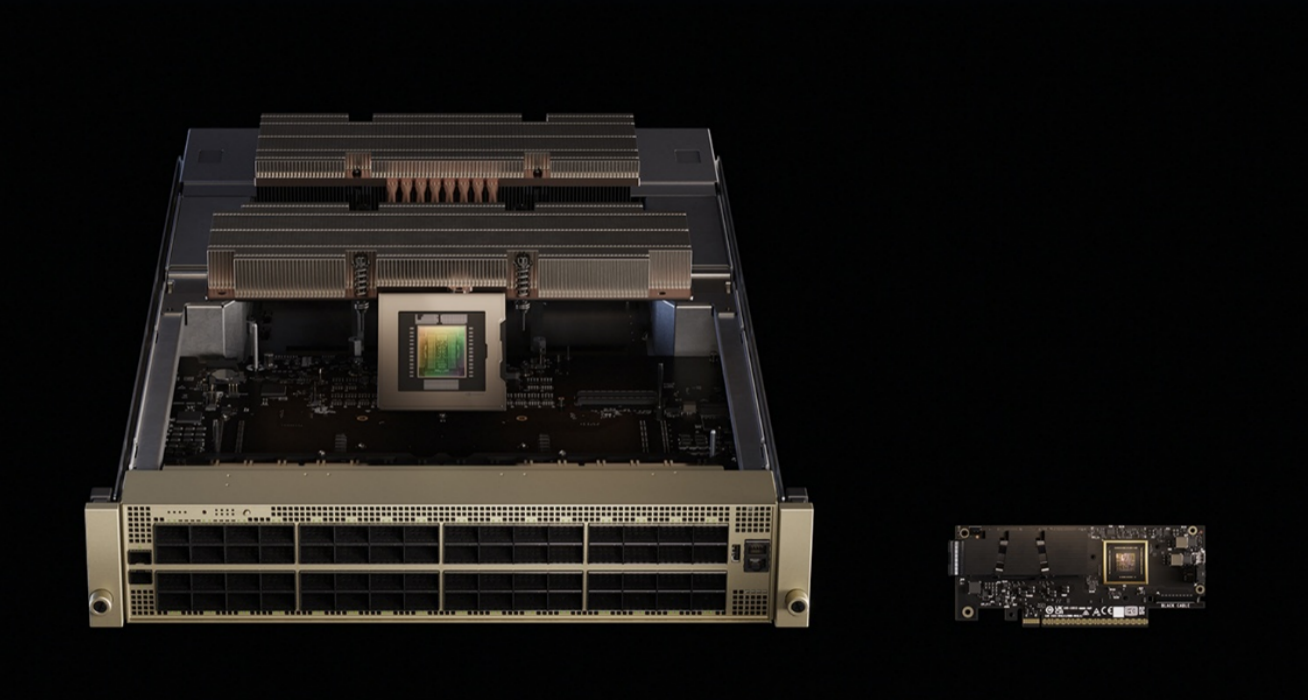

NVIDIA近日宣布,两大科技巨头Meta与Oracle 将在其下一代 AI 数据中心中大规模部署 NVIDIA Spectrum-X 以太网交换机与相关技术,分别将其并入 Meta 的开放交换系统 (FBOSS / Minipack3N) 与 Oracle 的“Giga-Scale”AI 工厂蓝图。此举被业界视为以太网向 AI 专用互连迈出的重要一步,也标志着超大规模企业在网络层面对专用化、可预测性能的追求进入新阶段。

为什么网络对万亿参数模型至关重要?

如今,大型生成式模型的训练不像传统分布式计算那样只受单台服务器或单链路限制。训练过程需要极高频次的全局参数同步、巨量梯度/激活的跨节点移动以及严格的延迟与带宽保障。如英伟达所述,网络在此承担三项关键角色:

吞吐(Throughput):高带宽只是基础,能够在多流/多路径场景下维持高利用率才是真正的价值。Spectrum-X 的拥塞控制与基于遥测的动态路由能把并发流冲突造成的带宽浪费降到最低,从而实现接近理论带宽的实际吞吐(厂方数据提到 ~95%)。

可预测性(Determinism):大规模训练对尾延迟(tail latency)极为敏感,某些关键通信若延迟飙升会导致同步阻塞。Spectrum-X 通过端到端的流控与 SuperNIC 协同,降低不可预测抖动,从而提升训练收敛的稳定性。

规模扩展(Scale-Across / Geo-Scale):Spectrum-XGS 等技术宣称支持“跨城、跨国、跨洲”的扩展能力,把分布式数据中心连接成统一的“Giga-Scale”工厂,帮助运营商和云厂商将算力池级联成更大粒度的训练平台。

从工程视角看,这意味着网络层面需要软硬件协同(交换机 ASIC + SuperNIC + 控制软件)以及实时遥测的数据闭环,才能在百万-GPU 级别上把“理想的”通信行为变成可复现的工程实践。NVIDIA 将 Spectrum-X 描述为“为全栈(GPU、NVLink、CPU、软件)量身定制的以太网平台”,目的正是打通计算与网络的性能缝隙。

Meta、Oracle的不同路径

不过,Meta 和 Oracle 在采用 Spectrum-X 上选择了不同的落地策略,各自围绕自身业务诉求做出优化。

Meta 的路线更侧重“开放可编排的网络平台”——将 Spectrum 系列与 FBOSS 结合、并在 Minipack3N 这类开源交换机设计上实现落地,体现了 Meta 在软硬分离、可编程控制面方面的持续投入。对 Meta 而言,目标是以开放规范支持其面向数十亿用户的生成式 AI 服务,既要高效也要可控。

Oracle 则更强调“工厂式的超大规模整合”——将 Vera Rubin 作为加速器架构、以 Spectrum-X 做为互联骨干,目标是把分散的数据中心、成千上万的节点聚合为统一的可编排超算平台,从而为企业级客户提供端到端的训练与推理服务。Oracle 管理层将此类部署称为“Giga-Scale AI 工厂”,并将其作为云竞争中的差异化基石。

无论路线如何不同,二者的共同点十分明显:当算力持续呈指数级增长时,网络层决定了这些“理论上的算力”能否转化为“实际可用的吞吐与业务价值”。

将实际吞吐从 ~60% 提升到 ~95%(厂方宣称数据)不仅是技术指标的改进——它直接转化为:更短的训练时间:模型训练迭代从数周/数月缩短,研发与产品化节奏加快;更低的算力闲置率:服务器和 GPU 的有效利用率上升,单位模型训练的资本开销 (CapEx) 与运行开销 (OpEx) 显著下降;在能效收益方面,在同等完成度下,节约的能耗与冷却开销能为超大规模部署带来可观的长期成本回报。

对于以“时间就是竞争力”为核心的模型厂商而言,网络效率的提升直接等价于“更快推出更强模型”的能力,这也是 Meta 与 Oracle 迅速拥抱 Spectrum-X 的商业逻辑所在。

结语

NVIDIA 将 Spectrum-X 描绘为“AI 工厂的神经系统”,Meta 与 Oracle 的快速跟进证明了:在 AI 时代,网络从边缘基础设施跃升为核心竞争力。短期内我们会看到更多硬件—软件—运营三位一体的联合方案走向产业化;中长期,这类面向 AI 优化的网络设计可能成为新一代数据中心标准的一部分。对于希望在训练规模与速度上实现质的飞跃的企业而言,网络不再是附属品,而是必须首先被认真设计的“主角”。

责任编辑:duqin

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻