打出NPU和CPU组合牌,Arm全面发力边缘AI

2025-11-05

17:56:55

来源: 互联网

点击

近年来的人工智能大热,除了让GPU成为风口浪尖的畅销产品外,有一类名为NPU的产品也备受关注。

所谓NPU(Neural Processing Unit),也就是我们常说的神经处理单元——一种专门用于加速人工智能 (AI) 和机器学习任务的处理器。与CPU和GPU不同,NPU是专为神经网络的平行运算需求而优化,能更高效地处理图像识别、语音处理等任务,同时也常被用作物联网设备、移动设备、个人计算机和智能汽车等端侧领域的AI加速器。随着AI的快速发展,为所有端侧应用增加这种加速器的需求的也正在大幅增加。

知名分析机构SHD Group在《边缘 AI 市场分析报告》中指出,到 2030 年,基于边缘 AI 的系统级芯片 (SoC) 市场营收规模将达到 800 亿至 1,000 亿美元。VDC Research在其报告也披露,到 2028 年,AI 将成为物联网 (IoT) 各类项目中应用占比最高的主导性技术。

由此可见,作为端侧AI计算的核心,NPU已事实上成为了几乎所有SoC的头等大事。

边缘 AI 时代已经到来

“边缘 AI 时代已经到来,它正在不断演进与发展,我们也正在见证越来越多新边缘计算项目的出现。”Arm 物联网事业部硬件产品管理高级总监 Lionel Belnet日前在深圳举办的Arm Unlocked 2025 AI 技术峰会上与半导体行业观察等沟通的时候如是说。

诚然,通过将先进的计算能力直接部署设备边缘端带来的革命性体验也是显而易见的。想象一下,无需云连接即可运行的私有设备端人工智能助手和语音界面,响应延迟极低;聊天机器人会在你输入时提供回复建议;游戏体验能够实时适应每位玩家;可穿戴设备和物联网设备中更智能、始终在线、节能的传感器,能够以低能耗提供强大的智能。

Lionel Belnet也总结道,从边缘 AI 迈向通用 AI ,会带来五个优势,分别是延迟、安全、能效、成本和可靠性。“因为能够在本地完成实现计算,无需依赖网络或云端,并能通过专用硬件处理特定任务。这就降低了边缘设备的成本,增强了系统韧性。即使处于离线状态,设备仍可持续运行,持续提供安全可靠的服务。”Lionel Belnet解析说。

正因为有了上述几点优势,边缘人工智能给终端用户带来的体验也是前所未有的。

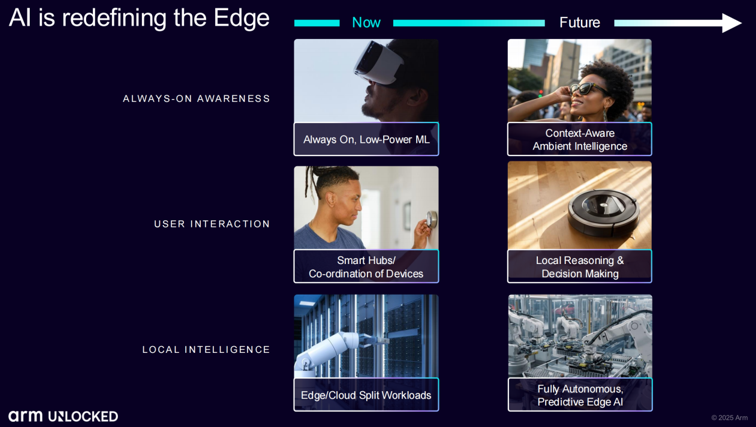

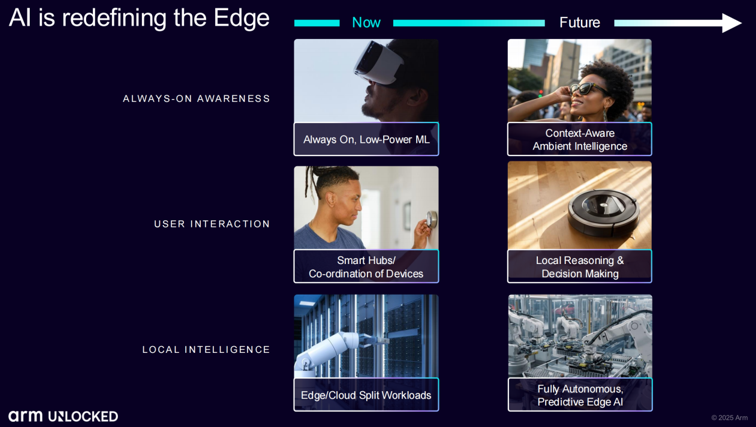

首先,“始终在线 (Always-on)”的感知能力是提升边缘设备用户交互体验的关键途径之一,其包括实时响应、通过本地数据存储提升隐私保护,以及在设备端直接运行复杂AI模型的能力等优势十分明显;其次,无缝的用户交互体验也是其不得不谈的另一个优势,这让终端可持续保持场景感知能力;边缘人工智能的第三个优势在于本地智能能力,这让它即使在离线状态下,系统仍能做出安全稳定的响应。

以人机交互边缘 AI 应用为例,搭载端侧智能的设备能够感知场景、准确识别当前状态、识别参与者身份、理解用户交互意图,并通过本地化智能处理,让数据无需上传云端即可在本地完成计算,这不仅增强了安全性,也让系统响应更具可预测性。从感知与识别的角度来看,又由于边缘 AI 能够在极低功耗下运行,这对于人机界面 (HMI) 也尤为重要。

在Lionel Belnet看来,边缘人工智能有望在工业自动化市场持续引领应用落地:制造商正将自动化控制、预测性维护以及基于计算机视觉的质检技术部署到工厂生产场景中;智能家居与可穿戴设备(如智能眼镜)将紧随其后,目前已展现出强劲发展势头。此外,智慧城市领域也将快速成长:本地化且注重隐私保护的人工智能处理技术,能优化能源利用和交通管理等;而从智能摄像头到机器人等具备场景感知能力的人工智能设备,也将迎来快速增长。

但要实现上述目标,就需要适合边缘端AI应用的软硬件解决方案,这正是Arm过去多年深耕的方向。

CPU+NPU,Arm多管齐下

自1990年以来,Arm就在CPU领域进行深耕,公司在这方面的实力毋庸置疑。Arm在过去多年的发展中也发展出了一系列知名的产品线。

但如Arm所说,随着人工智能工作负载的不断增加,计算需求也日趋增长,片上系统 (SoC) 的能效比以往任何时候都更加重要。正因如此,Arm在所有关键市场——基础设施、客户端、汽车以及面向物联网的边缘人工智能平台——都推出了 Arm 计算子系统 (Compute Subsystem, CSS),当中包括了面向基础设施的Arm Neoverse 、面向PC 的Arm Niva 、面向移动的Arm Lumex 、面向汽车的Arm Zena以及面向物联网的Arm Orbis。在Arm看来,借助这种方式,公司的合作伙伴能够更快、更自信、更轻松地集成Arm技术——尤其是在他们扩展规模以满足人工智能需求时。

基于这些积累,Arm展示了运行在基于 Arm 架构 MCU (Cortex-M85 与 Ethos-U85 的)的复杂语音模型,实现了高速低延迟的语音识别与超低功耗表现。这正是高性能语音用户界面的理想解决方案,这也代表了当今业界的领先水平。

然而,正如Lionel Belnet所说,边缘AI未来还有更广阔的发展空间。于是为了加速边缘 AI 的发展,Arm正将物联网的性能从传统 MCU 扩展到更复杂的边缘 AI 系统,公司今年年初更是推出的全球首个基于 Armv9 架构、以 Arm Cortex-A320 CPU 和 Arm Ethos-U85 NPU 为核心的边缘 AI 计算平台,就是公司为这个市场准备的另一个重要支撑。

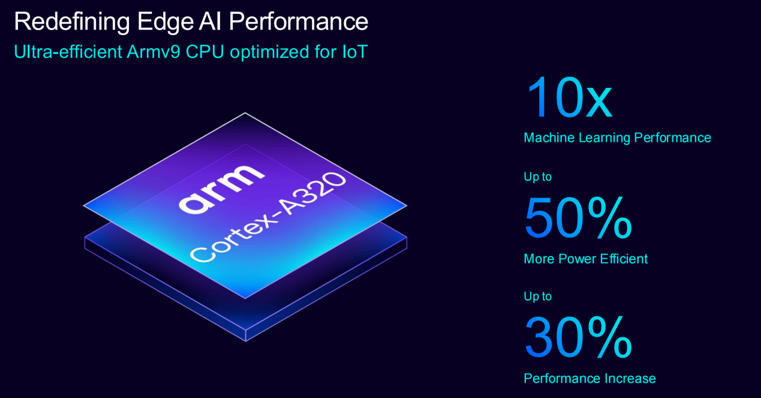

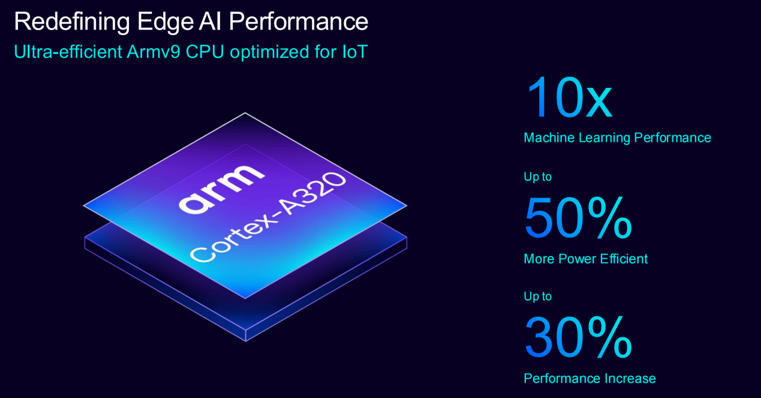

据介绍,作为首款超高能效 Armv9 CPU,Arm Cortex-A320兼具强劲的性能、熟悉的开发环境,并具备运行更大规模语言模型的能力(能支持运行超 10 亿参数的端侧 AI 模型)。与前代产品相比,Cortex-A320 充分发挥了 Armv9 架构的优势,如针对机器学习 (ML) 性能的第二代可伸缩矢量扩展 (SVE2)。相较于前代产品 Arm Cortex-A35,Cortex-A320 的 ML 性能提升了十倍,标量性能提升了 30%,标志着重大的技术飞跃。

至于Arm Ethos-U85 NPU,则是Arm面向人工智能需求打造的另一系列旗舰产品。

据介绍,Arm Ethos-U85 的 MAC 单元(乘加单元)数量可从 128 个扩展到 2048 个。与前代产品 Ethos-U65 相比,能效提升了 20%。Arm表示,在采用 2048 个 MAC 单元配置时,该芯片的运算速度可达 4 TOPS。在实际演示中,Arm使用了 FPGA 上 512 个 MAC 单元的较小配置,仅需 32 MHz 的运行频率即可运行拥有 1500 万个参数的 Tiny Llama2 小型语言模型。

Ethos-U85 的一个显著特点是其原生支持 Transformer 网络,而早期版本并不支持。Ethos -U85 还能为使用先前 Ethos-U NPU 的合作伙伴提供了无缝迁移方案,使他们能够充分利用在基于 Arm 的机器学习工具方面的现有投资。

在Arm看来,Ethos-U85 的这一能力凸显了将 AI 直接嵌入设备的巨大潜力。即使在内存有限(320 KB SRAM 用于缓存,32 MB 用于存储)的情况下,Ethos-U85 也能高效处理此类工作负载,从而为小型语言模型和其他 AI 应用在深度嵌入式系统中蓬勃发展铺平了道路。

日前,Arm更是将该平台纳入了 Arm 技术授权订阅模式中的 Arm Flexible Access 方案,助力初创企业与 OEM 厂商加速下一代智能边缘设备的研发进程。截至目前,Arm Flexible Access 方案已拥有 300 余家活跃成员,其中,中国企业超过 70 家,全球累计实现超 400 次成功流片,持续为整个生态系统注入快速创新动力。

对于Arm体系的参与者来说,性能卓越的硬件只是他们看中这个巨头的一个方面,丰富的生态支持,则是Arm用户拥抱这家巨头的另一个重要原因。

Lionel Belnet在与半导体行业观察交流的时候也直言,Arm CPU 架构的优势体现在其对各类应用的广泛兼容性。Arm NPU也能共享Arm过去积累的很多生态资源。借助CPU+NPU 的产品组合,Arm能为如穿戴设备(手表、手环)和物联网设备等需要在严苛的能耗限制下实现强大的计算能力的边缘智能提供支持。

“Arm CPU+NPU 的产品组合非常适用于高能效应用场景”,Lionel Belnet重申。

写在最后

虽然Arm对这个市场高度关注,且动作频频。但无可否认的是,Arm无论是在CPU还是NPU端,都在面临越来越多挑战者的竞争。对此,Lionel Belnet表示,Arm会坚持持续创新,因为只有通过前沿技术不断突破创新边界,推动技术发展,才能确保 Arm 始终保持行业技术领先地位。

与此同时,Arm还将优化商业模式并确保灵活的可获取性。具体而言,则采取包括简化销售流程、加强与合作伙伴的互动,帮助他们更便捷地获取 Arm 的最新先进技术。“无论是在技术层面还是商业模式层面,这两点对于 Arm 在中国乃至全球保持领先地位至关重要。”Lionel Belnet说。

此外,Arm还将持续构建广泛的软件生态。作为全球应用最广泛的计算平台,Arm 拥有全球规模最大的计算生态系统,以及超过 2200 万名软件开发者;软件技术方面,Arm KleidiAI 软件库已经集成到多个主流 AI 框架,包括 Llama.cpp、ExecuTorch 和 LiteRT,能够对Meta Llama 3 和 Phi-3 等主流AI 大模型进行加速,进一步释放 AI 计算性能。

Lionel Belnet认为,AI的未来在边缘,但AI 的终点不在边缘,而是始于边缘,并从边缘侧推动着下一波智能计算的浪潮。“Arm 致力于构建一个开源、标准化的生态系统,通过提供开放标准与开源资源,赋能开发者在生态内自主获取所需工具,持续激发创新潜能。”Lionel Belnet最后说。

所谓NPU(Neural Processing Unit),也就是我们常说的神经处理单元——一种专门用于加速人工智能 (AI) 和机器学习任务的处理器。与CPU和GPU不同,NPU是专为神经网络的平行运算需求而优化,能更高效地处理图像识别、语音处理等任务,同时也常被用作物联网设备、移动设备、个人计算机和智能汽车等端侧领域的AI加速器。随着AI的快速发展,为所有端侧应用增加这种加速器的需求的也正在大幅增加。

知名分析机构SHD Group在《边缘 AI 市场分析报告》中指出,到 2030 年,基于边缘 AI 的系统级芯片 (SoC) 市场营收规模将达到 800 亿至 1,000 亿美元。VDC Research在其报告也披露,到 2028 年,AI 将成为物联网 (IoT) 各类项目中应用占比最高的主导性技术。

由此可见,作为端侧AI计算的核心,NPU已事实上成为了几乎所有SoC的头等大事。

边缘 AI 时代已经到来

“边缘 AI 时代已经到来,它正在不断演进与发展,我们也正在见证越来越多新边缘计算项目的出现。”Arm 物联网事业部硬件产品管理高级总监 Lionel Belnet日前在深圳举办的Arm Unlocked 2025 AI 技术峰会上与半导体行业观察等沟通的时候如是说。

诚然,通过将先进的计算能力直接部署设备边缘端带来的革命性体验也是显而易见的。想象一下,无需云连接即可运行的私有设备端人工智能助手和语音界面,响应延迟极低;聊天机器人会在你输入时提供回复建议;游戏体验能够实时适应每位玩家;可穿戴设备和物联网设备中更智能、始终在线、节能的传感器,能够以低能耗提供强大的智能。

Lionel Belnet也总结道,从边缘 AI 迈向通用 AI ,会带来五个优势,分别是延迟、安全、能效、成本和可靠性。“因为能够在本地完成实现计算,无需依赖网络或云端,并能通过专用硬件处理特定任务。这就降低了边缘设备的成本,增强了系统韧性。即使处于离线状态,设备仍可持续运行,持续提供安全可靠的服务。”Lionel Belnet解析说。

正因为有了上述几点优势,边缘人工智能给终端用户带来的体验也是前所未有的。

首先,“始终在线 (Always-on)”的感知能力是提升边缘设备用户交互体验的关键途径之一,其包括实时响应、通过本地数据存储提升隐私保护,以及在设备端直接运行复杂AI模型的能力等优势十分明显;其次,无缝的用户交互体验也是其不得不谈的另一个优势,这让终端可持续保持场景感知能力;边缘人工智能的第三个优势在于本地智能能力,这让它即使在离线状态下,系统仍能做出安全稳定的响应。

以人机交互边缘 AI 应用为例,搭载端侧智能的设备能够感知场景、准确识别当前状态、识别参与者身份、理解用户交互意图,并通过本地化智能处理,让数据无需上传云端即可在本地完成计算,这不仅增强了安全性,也让系统响应更具可预测性。从感知与识别的角度来看,又由于边缘 AI 能够在极低功耗下运行,这对于人机界面 (HMI) 也尤为重要。

在Lionel Belnet看来,边缘人工智能有望在工业自动化市场持续引领应用落地:制造商正将自动化控制、预测性维护以及基于计算机视觉的质检技术部署到工厂生产场景中;智能家居与可穿戴设备(如智能眼镜)将紧随其后,目前已展现出强劲发展势头。此外,智慧城市领域也将快速成长:本地化且注重隐私保护的人工智能处理技术,能优化能源利用和交通管理等;而从智能摄像头到机器人等具备场景感知能力的人工智能设备,也将迎来快速增长。

但要实现上述目标,就需要适合边缘端AI应用的软硬件解决方案,这正是Arm过去多年深耕的方向。

CPU+NPU,Arm多管齐下

自1990年以来,Arm就在CPU领域进行深耕,公司在这方面的实力毋庸置疑。Arm在过去多年的发展中也发展出了一系列知名的产品线。

但如Arm所说,随着人工智能工作负载的不断增加,计算需求也日趋增长,片上系统 (SoC) 的能效比以往任何时候都更加重要。正因如此,Arm在所有关键市场——基础设施、客户端、汽车以及面向物联网的边缘人工智能平台——都推出了 Arm 计算子系统 (Compute Subsystem, CSS),当中包括了面向基础设施的Arm Neoverse 、面向PC 的Arm Niva 、面向移动的Arm Lumex 、面向汽车的Arm Zena以及面向物联网的Arm Orbis。在Arm看来,借助这种方式,公司的合作伙伴能够更快、更自信、更轻松地集成Arm技术——尤其是在他们扩展规模以满足人工智能需求时。

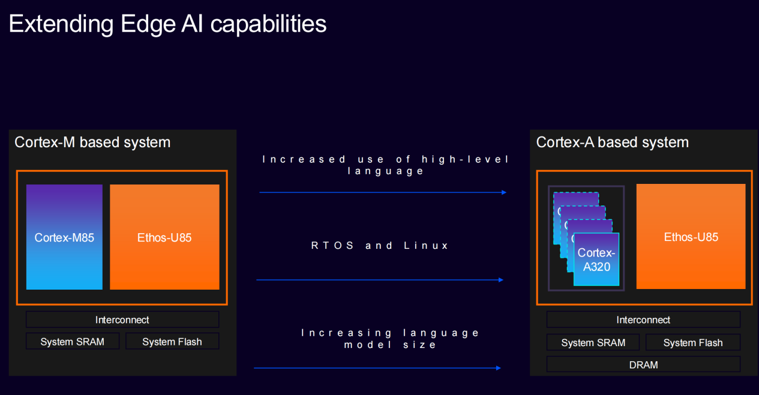

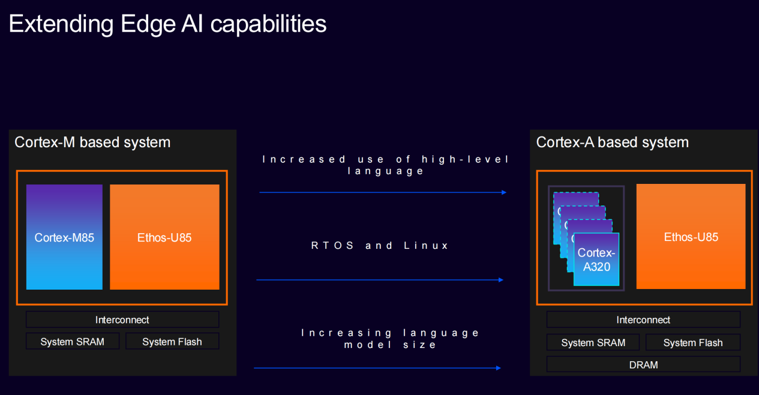

基于这些积累,Arm展示了运行在基于 Arm 架构 MCU (Cortex-M85 与 Ethos-U85 的)的复杂语音模型,实现了高速低延迟的语音识别与超低功耗表现。这正是高性能语音用户界面的理想解决方案,这也代表了当今业界的领先水平。

然而,正如Lionel Belnet所说,边缘AI未来还有更广阔的发展空间。于是为了加速边缘 AI 的发展,Arm正将物联网的性能从传统 MCU 扩展到更复杂的边缘 AI 系统,公司今年年初更是推出的全球首个基于 Armv9 架构、以 Arm Cortex-A320 CPU 和 Arm Ethos-U85 NPU 为核心的边缘 AI 计算平台,就是公司为这个市场准备的另一个重要支撑。

据介绍,作为首款超高能效 Armv9 CPU,Arm Cortex-A320兼具强劲的性能、熟悉的开发环境,并具备运行更大规模语言模型的能力(能支持运行超 10 亿参数的端侧 AI 模型)。与前代产品相比,Cortex-A320 充分发挥了 Armv9 架构的优势,如针对机器学习 (ML) 性能的第二代可伸缩矢量扩展 (SVE2)。相较于前代产品 Arm Cortex-A35,Cortex-A320 的 ML 性能提升了十倍,标量性能提升了 30%,标志着重大的技术飞跃。

至于Arm Ethos-U85 NPU,则是Arm面向人工智能需求打造的另一系列旗舰产品。

据介绍,Arm Ethos-U85 的 MAC 单元(乘加单元)数量可从 128 个扩展到 2048 个。与前代产品 Ethos-U65 相比,能效提升了 20%。Arm表示,在采用 2048 个 MAC 单元配置时,该芯片的运算速度可达 4 TOPS。在实际演示中,Arm使用了 FPGA 上 512 个 MAC 单元的较小配置,仅需 32 MHz 的运行频率即可运行拥有 1500 万个参数的 Tiny Llama2 小型语言模型。

Ethos-U85 的一个显著特点是其原生支持 Transformer 网络,而早期版本并不支持。Ethos -U85 还能为使用先前 Ethos-U NPU 的合作伙伴提供了无缝迁移方案,使他们能够充分利用在基于 Arm 的机器学习工具方面的现有投资。

在Arm看来,Ethos-U85 的这一能力凸显了将 AI 直接嵌入设备的巨大潜力。即使在内存有限(320 KB SRAM 用于缓存,32 MB 用于存储)的情况下,Ethos-U85 也能高效处理此类工作负载,从而为小型语言模型和其他 AI 应用在深度嵌入式系统中蓬勃发展铺平了道路。

日前,Arm更是将该平台纳入了 Arm 技术授权订阅模式中的 Arm Flexible Access 方案,助力初创企业与 OEM 厂商加速下一代智能边缘设备的研发进程。截至目前,Arm Flexible Access 方案已拥有 300 余家活跃成员,其中,中国企业超过 70 家,全球累计实现超 400 次成功流片,持续为整个生态系统注入快速创新动力。

对于Arm体系的参与者来说,性能卓越的硬件只是他们看中这个巨头的一个方面,丰富的生态支持,则是Arm用户拥抱这家巨头的另一个重要原因。

Lionel Belnet在与半导体行业观察交流的时候也直言,Arm CPU 架构的优势体现在其对各类应用的广泛兼容性。Arm NPU也能共享Arm过去积累的很多生态资源。借助CPU+NPU 的产品组合,Arm能为如穿戴设备(手表、手环)和物联网设备等需要在严苛的能耗限制下实现强大的计算能力的边缘智能提供支持。

“Arm CPU+NPU 的产品组合非常适用于高能效应用场景”,Lionel Belnet重申。

写在最后

虽然Arm对这个市场高度关注,且动作频频。但无可否认的是,Arm无论是在CPU还是NPU端,都在面临越来越多挑战者的竞争。对此,Lionel Belnet表示,Arm会坚持持续创新,因为只有通过前沿技术不断突破创新边界,推动技术发展,才能确保 Arm 始终保持行业技术领先地位。

与此同时,Arm还将优化商业模式并确保灵活的可获取性。具体而言,则采取包括简化销售流程、加强与合作伙伴的互动,帮助他们更便捷地获取 Arm 的最新先进技术。“无论是在技术层面还是商业模式层面,这两点对于 Arm 在中国乃至全球保持领先地位至关重要。”Lionel Belnet说。

此外,Arm还将持续构建广泛的软件生态。作为全球应用最广泛的计算平台,Arm 拥有全球规模最大的计算生态系统,以及超过 2200 万名软件开发者;软件技术方面,Arm KleidiAI 软件库已经集成到多个主流 AI 框架,包括 Llama.cpp、ExecuTorch 和 LiteRT,能够对Meta Llama 3 和 Phi-3 等主流AI 大模型进行加速,进一步释放 AI 计算性能。

Lionel Belnet认为,AI的未来在边缘,但AI 的终点不在边缘,而是始于边缘,并从边缘侧推动着下一波智能计算的浪潮。“Arm 致力于构建一个开源、标准化的生态系统,通过提供开放标准与开源资源,赋能开发者在生态内自主获取所需工具,持续激发创新潜能。”Lionel Belnet最后说。

责任编辑:Ace

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻